/https://www.webnews.it/app/uploads/2016/04/tensorflow.jpg)

Il progetto TensorFlow è stato lanciato da soli cinque mesi, ma l’interesse riscontrato è stato tale da averlo già eletto come il più biforcato su GitHub, nonché il più popolare tra quelli che rientrano nella categoria machine learning. Oggi Google annuncia l’esordio della versione 0.8, che permette alle community di sviluppatori e ricercatori di sfruttarlo facendo leva sulle potenzialità del calcolo distribuito.

Un annuncio giunto a pochi giorni di distanza da quello relativo al Google Cloud Machine Learning, che mette a disposizione di chi crea applicazioni e servizi la stessa tecnologia alla base di numerosi prodotti del gruppo di Mountain View, in grado di vedere, ascoltare e capire il mondo che circonda l’utente e i suoi dispositivi. L’architettura distribuita di TensorFlow offre innanzitutto flessibilità e adattabilità ad applicazioni di ogni tipo. Gli sviluppatori, da oggi, possono inoltre impiegare le librerie Python incluse per semplificare la scrittura di modelli eseguiti da un singolo processo e scalabili.

Oggi siamo felici di rilasciare TensorFlow 0.8 con supporto al calcolo distribuito, che include tutto ciò di cui si ha bisogno per istruire i modelli distribuiti sulla vostra infrastruttura. Si basa sulla performante libreria gRPC, supportata al training su centinaia di macchine in parallelo.

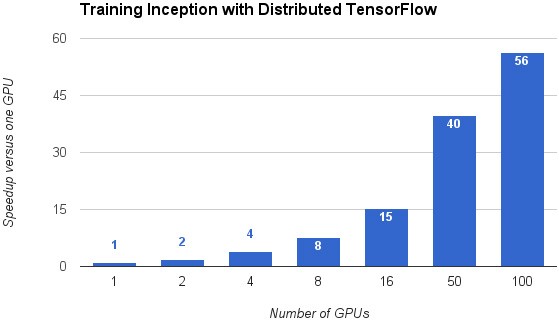

Insieme alla versione 0.8 di TensorFlow, Google ha pubblicato anche un trainer distribuito per il sistema di rete neurale Inception dedicato alla classificazione delle immagini. Il processo di apprendimento ha ichiesto meno di 65 ore, sfruttando un centinaio di GPU, arrivando ad un livello di precisione pari al 78%.

TensorFlow può velocizzare il training di Inception per un fattore di 56, utilizzando 100 GPU

Il team al lavoro sul progetto conferma l’intenzione di continuare a migliorarne l’efficacia e le performance, sia apportando ottimizzazioni dal punto di vista ingegneristico che rendendo più intelligenti gli algoritmi impiegati, sempre con l’obiettivo di rendere poi disponibili i passi in avanti compiuti all’intera community di GitHub.

/https://www.webnews.it/app/uploads/2025/06/wp_drafter_1218476.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1216842.jpg)

/https://www.webnews.it/app/uploads/2025/05/ChatGPT-google-chrome1.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1215321.jpg)