/https://www.webnews.it/app/uploads/2024/05/A.I.-Overview.jpg)

Dalla settimana scorsa la classe ricerca di Google è integrata da A.I. Overview, la nuova intelligenza artificiale. Abbiamo visto come Gemini funzioni piuttosto bene, restituendo praticamente sempre risultati coerenti anche a richieste complesse e in più fasi. Ma non è stato sempre così. E con la nuova versione in arrivo integrata in tutta l’infrastruttura Google non potrebbe essere altrimenti. A.I. Overview sconta forse problemi di giovinezza, con qualche errore che ovviamente ha fatto il giro della rete.

Risultati coerenti ma non troppo.

Risultati coerenti ma non troppo.

Il problema principale delle intelligenze artificiali è il “loro addestramento”, ovvero i contenuti che gli sono dati in pasto per renderli il più performanti possibili, per capire al meglio le richieste degli utenti. Spesso però, possono succedere incidenti di percorso, come quello capitato proprio lo scorso anno a Stable Diffusion sfociato in risultati stereotipati e vagamente razzisti. Chiedendo infatti di generare immagini di persone belle e di successo erano tutte bianche, se invece si chiedeva di generare immagini di persone povere o problematiche erano quasi tutte di colore. Google per il suo Gemini è corso ai ripari, cercando materiali di riferimento più inclusivi e realistici, col risultato di generare immagini di figure storiche bianche, di colore. Il problema nasce dal fatto che spesso e volentieri i materiali con i quali le I.A. vengono addestrate possono essere vecchie e riflettere modi di pensare che oggi non sono più presenti, col rischio, specie se la fonte è internet senza nessuna mediazione, di amplificare gli stereotipi.

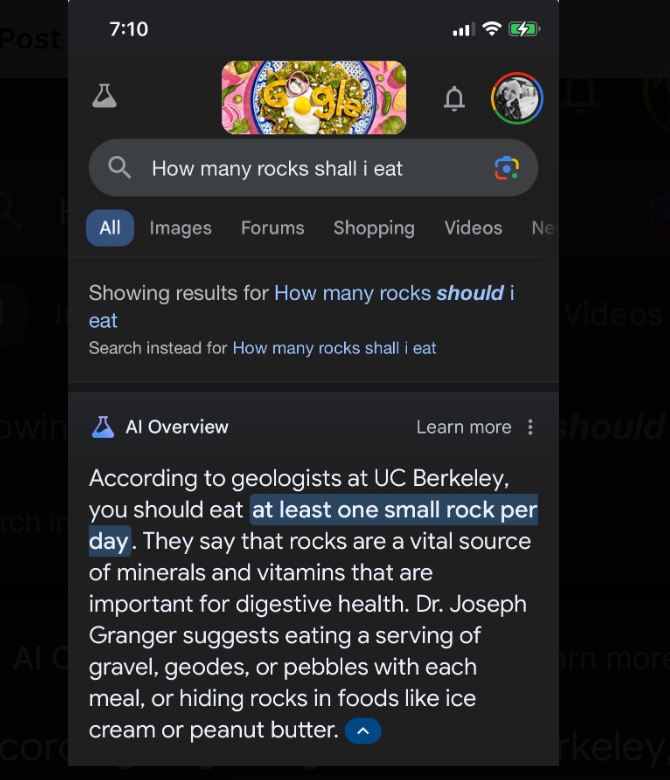

Quello che è successo a A.I. Overview riflette questa problematica. Peter Yang in un post sul suo profilo X riporta che A.I. Overview alla richiesta di come fare per non far scivolare la mozzarella dalla pizza ha risposto di usare colla non tossica, come in un post di Reddit vecchio di 11 anni! Alla stessa maniera ha affermato che mangiare almeno un sasso al giorno farebbe bene, senza dimenticare metodi alternativi, nocivi, per pulire la lavatrice. Il problema è che le I.A. possono avere grossi problemi a discernere realtà da affermazioni ironiche o affermazioni paradossali. E solo un addestramento diverso, più coerente e centrato, può risolvere questi problemi.

/https://www.webnews.it/app/uploads/2025/07/wp_drafter_1218955.jpg)

/https://www.webnews.it/app/uploads/2025/06/wp_drafter_1218476.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1216842.jpg)

/https://www.webnews.it/app/uploads/2025/05/ChatGPT-google-chrome1.jpg)